|

“AI 总统不会被游说” 从哈丁的茶壶山丑闻(美国时任内政部长亚伯特·富尔受贿,未用公开招标方式处理茶壶山以及另外两处的美国海军油矿),到尼克松的水门事件(尼克松的首席安全顾问闯入水门大厦安装窃听器并偷拍有关文件),还有克林顿因丑闻而丢掉饭碗,颠覆他们执政的都是人性的弱点:嫉妒、贪婪、欲望、裙带关系。 如今,一小部分科学家及研究者相信有一种替代方法,可以将领导人从他或她的人性弱点中拯救出来。一旦技术发展到一定程度,他们认为应该由计算机来统治世界。这听起来有点儿疯狂,但他们的想法是,人工智能,相比较任何人类,在面对重大、复杂的国家问题时可以做出更明智的决策,而且不会有现任人类领导者那些闹剧和短视冒失的行为。 如果你脑中已经在想象一个终结者形象的总统端坐在美国白宫总统办公桌后面,画风可能需要转变一下。那时的总统多半是放置在柜子里的一台计算机,忙于解决国家最棘手的问题。不同于人类,机器人在考量具体某一条政策可能引发的结果时会参考大量的数据。它可以预见到人类思维无法预见的隐患,不受冲动或偏见干扰地权衡利弊。这样,我们可以最终创造一个前所未有的勤勉、高效、积极应对民众需求的行政机关。 还并没有一个正规的统一的团体去推进机器人执掌国家,只是一支专家和理论家组成的“杂牌军”认为未来派的技术会带来更英明的执政,并最终创造一个更美好的国家。一位长期从事人工智能研究的专家Mark Waser称,一旦人工智能中的一些关键问题得到解决,机器人将会作出比人类更好的决策。 “倡导道德地使用技术来扩展人的能力”的非营利组织“Humanity+” 的女主席Natasha Vita-More认为,我们有一天会有一个“后人类”的领导者——这个领导人没有身体,而是以另外的方式存在,比如上传到电脑的人类思维。 机器领袖如何融入现有制度关于机器人统治者的想法已经在科幻小说中存在了数十年。 1950 年,Isaac Asimov的短篇故事集“我,机器人”设想了一个机器具有了意识和人类水平智能的世界。他们受到“机器人三定律”的控制(第一条是:机器人不能伤害人类,或者通过不作为,让人类受到伤害)。 在著名科幻小说家Iain Banks的《文明》系列中,超级AI扮演着政府的角色,计算着怎样组织社会和分配资源才是最佳方式。 流行文化,比如电影《Her》,也一直在期待类人机器。 但到目前为止,机器人总统还只出现在这些故事中,但也许过不了多久,AI领袖就会出现。 当然,用机器人代替一个领导者并不简单,即使那些在努力推动这个想法的人,也承认存在着严重的障碍。 别的不说,机器领袖该如何融入现有制度?有人设想,届时将定期让民众投票,为机器人决定优先事项,以及如何处理一些道德相关的问题;民众将有机会在下次投票中改变这些选择。系统的初始编程无疑将是有争议的,程序员很可能也需要共同入选。 机器人领导者需要通用人工智能从技术的角度来看,人工智能还不够聪明,无法管理国家。机器人目前可以完成的工作列表确实很长,从诊断疾病,到驾驶汽车,再到赢得各种游戏,以及在你的智能手机上回答问题——它成长迅速,但是现在,我们所有的AI系统使用的都还是弱人工智能,这意味着它们需要专门编程才能执行任何给定的任务。 而显然,领导一个国家要做的远不止一个“任务”。 “如果你是美国总统,你要解决的是你这个层面上没有其他人能够解决的问题。等着你砸的是那些最硬的坚果。”CMU的机器人学教授Illah Nourbakhsh曾说过“最难破解的难题是认知方式。没有太多先例可供参考,你必须使用最富创造性的思维。” 为了实现这一切,机器人将需要科学家所说的通用人工智能,也被称为“强人工智能”——与人类智能一样广泛、富于创造性和灵活性的智能。当然,强人工之智能还没有出现,但有些专家认为即将到来。 Waser说:“有一些人相信人类水平的人工智能将比预想中来的早得多,我就是这些人之一。2008年那会儿,我表示那会在2025年左右到来。十年后,我看不出有什么理由要修改这个预判。”Vita-More也同意这个观点,她预测10–15年内就可以有一个早期版本的强人工智能。 但是,这种乐观的估计是基于一个关键的假设:我们很快就会来到计算机自我解决问题的时代——科学家们称之为“技术奇点”。在那个时间点上,计算机将比人类变得更聪明,甚至可以自己设计出更新更智能的计算机。然而,Nourbakhsh说,他不认为所有涉及开发更好的计算机的技术问题都可以通过机器来解决。有些还有赖于新的化学发现或者用于构建这些超级计算机的新型材料的发明。 AI的不可解释性在AI管理国家之前,需要解决的另一大技术问题是:机器人不知道如何解释自己。AI接收信息,做出决策,但没人知道为什么机器会做出这个选择——这对于需要不断做出决策的工作来说是个大问题,况且这些决策还伴随着不可预测的投入和严重的后果。 而一台计算机,至少现在还做不到这一点。 “机器必须能够与其他机器合作,才能有效。”Waser这样说,“它们必须与人类合作,才能安全”。而如果你不能向别人解释你的思维过程,那么合作会很艰难。 这个缺陷部分是因为AI的工作方式。在称为机器学习的方法中,计算机分析如山的数据,并找到可能对计算机而不是对人类有意义的模式。在称为深度学习的变体方法中,中间层对于任何外部人类观察者都是不透明的——计算机只会给出最终的结果。 “你可以带你孩子去看电影,然后由此聊开去,聊聊他们的心情,进行一个真正有趣又深入的谈话。”Nourbakhsh说,“但AI做不到这点,因为AI不理解从一个小话题向一个大话题的转换。” 技术体系无法免于偏见即使我们可以解决所有这些问题,机器人仍然可能不是我们想像的决策者。机器人领袖的主要优势之一就是能够统揽数据,而且能够做出决定,不带人类的偏见。但即使这样的优势,也并不明确——研究人员发现很难教AI系统完全避免偏见。 例如,2015年发布的谷歌照片应用程序使用AI识别照片的内容,然后对照片进行分类。该应用程序做得不错,却犯了一个明显的错误:它将几张黑人的照片标记为“大猩猩”。系统完全意识不到自己犯了怎样的错误,更理解不了其中牵涉的令人震惊的历史和社会背景。 还有一些例子,也影响了人类的生活。一个全国法院都在使用的AI能够判断被告重新犯罪的风险,并为法官的判决做出指导。它似乎是这种自动化技术的完美应用。它可以会处理大量的数据,找到人们可能会错过的模式,并避免困扰人类法官和检察官的偏见。但是,ProPublica的调查报告发现,黑人被告被AI系统认为在未来进行暴力犯罪的可能性要比白人被告高出77%(创建该系统的营利性公司对ProPublica的调查结果提出异议)。AI系统并没有明确地考虑被告的种族,而是因为一些与贫困和失业相关的因素与种族相关。系统基于这些数据,给出了这样的结果,虽然它的表面上是中立的,却是数百年不平等现象的沉淀。 这对所有计算机来说都是问题:它们的输出只是输入的忠实体现。一个被投喂了种族主义滋养的数据的AI,就可能生成种族主义的结果。 “技术体系无法免于偏见,不会因为只是数字就自动变得公平。”哥伦比亚大学文化人类学家Madeleine Clare Elish说,“我最大的恐惧是,人们无法接受AI技术的人类开发者将自身的偏见和缺陷也编码其中。” Nourbakhsh表示,所谓依靠强人工智能来解决AI的现有问题,大多是文字游戏。他说:“如果你提出一个问题,就会有人说‘这些AI智能超过人类,所以它们自己会找到解决这个问题的办法。”Nourbakhsh认为,人类必须自己解决问题。 人机协作也许更高效以上列举的障碍会使机器人总统拥趸沮丧和泄气,不过目前也许可以有一个折中的方法:计算机可以处理所有领导者需要做的决策,自己并不做出最终选择,而是给予人类元首做决策的指导。这类似于一种人机协作,协作的结果优于任何一方独自决策的结果。 哈佛法学院互联网法学教授Jonathan Zittrain认为尽管AI存在缺陷,计算机仍可被用于消除人类的做决策时的偏见。在近日的一篇博客中他写道:“经过适当的训练,AI能够系统地识别整体的不公正性及具体的偏见。” 也许让一台计算机与总统协同工作,仍旧可以修正人类领导者的一些缺陷。(作者:Michael Linhorst,编译:熊笑,实习编辑:张凯凯) (责任编辑:佚名) |

高层论坛 | 省部长论坛 | 理论探索 | 强国论坛 | 党政建设 | 政策研究 | 军事纵横 | 区域发展 | 风云人物 | 时事观察 | 小康中国 | 海峡两岸 | 艺术纵横 | 文明时代 | 本站专访 | 房地产风云 | 外商投资 | 企业风云 | 城市评论 | 新闻评论 | 经济评论 | 时政论坛 | 国际论坛 | 民生论坛 | 深度看点 | 财经论坛 | 教育留学 | 传统文化 | 科技探索 | 母婴保健 | 市县巡礼 | 时尚购物 | 评论电视 | 评论电台 | 民风民俗 | 国学儒风 | 妇女儿童 | 糖酒文化 | 航空航天 | 中评音乐 | IT数码 | 美食频道 | 北京 | 天津 | 上海 | 重庆 | 河北 | 河南 | 云南 | 辽宁 | 黑龙江 | 湖南 | 安徽 | 山东 | 新疆 | 江苏 | 浙江 | 江西 | 湖北 | 广西 | 甘肃 | 山西省 | 内蒙 | 吉林 | 福建 | 贵州 | 广东 | 青海 | 西藏 | 四川 | 宁夏 | 海南 | 台湾 | 香港 | 澳门 | 陕西 | 亚太聚焦 | 非洲频道 | 欧洲频道 | 区块链 | 两会频道 | 澳洲频道 | 国际经济 | 美洲频道 | 财富领袖 | 新硬件时代 | 物联网 | 一带一路 | 粤港澳大湾区 | 雄安新区 | 人工智能 | 民政工会 | 运动竞技 | 晚霞溢彩 | 人社保障 | 科技工业 | 建设兵团 | 投资发展 | 脱贫攻坚 | 产业联盟 | 网络金融 | 智慧城市 | 实业发展 | 科技创新 | 国际交流 | 会议专题 | 特色小镇 | 互联网+ |

机器人领导国家?为何机器人难以超越人类领袖?

时间:2017-07-16 16:07来源:新华网 作者:未知 点击:

次

“倡导道德地使用技术来扩展人的能力”的非营利组织“Humanity+” 的女主席Natasha Vita-More认为,我们有一天会有一个“后人类”的领导者——这个领导人没有身体,而是以另外的方式存在,比如上传到电脑的人类思维。

顶一下

(0)

0%

踩一下

(0)

0%

------分隔线----------------------------

- 发表评论

-

- 最新评论 进入详细评论页>>

- 精彩文章

-

- 收款二维码还能不能用了?央行最新权威解读来

人民银行有关人士给记者打了个比方:如果消费者在早点摊购买煎饼果子习惯用手机支付,...

- 这个“码假”必须狠狠追打!

在冬季疫情反弹和各地防控措施的升级的背景下,一起涉疫网络违法案件引起舆论哗然。有...

- 启动数字经济新引擎

15种新业态新模式创造中国发展新机遇。...

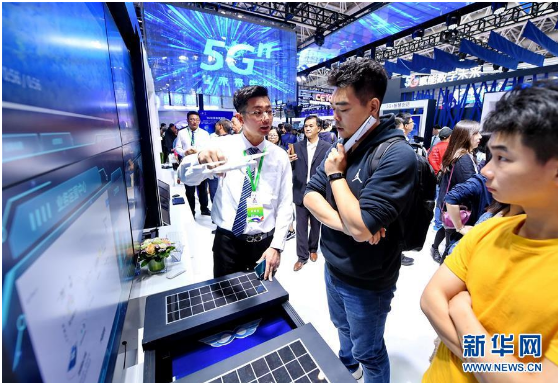

- 5G牌照发放,对你我意味着什么?

工信部近日表示,中国一如既往地欢迎国内外企业积极参与中国5G网络建设和应用推广,共...

- 从“数字中国”看中国发展新信号

“数字中国建设背后,是全球性的数字化浪潮,这股浪潮正在全球形成新一次技术革命。”...

- “大数据杀熟”带来监管挑战

任何技术的价值观,说到底还是人的价值观。技术中立不代表对技术的使用是无害的,失去...

- 收款二维码还能不能用了?央行最新权威解读来

- 中央文献网

- 中央编制办

- 国务院台办

- 中央统战部

- 中国长安网

- 中共中央党校

- 毛主席纪念堂

- 邓小平纪念馆

- 中国台湾网

- 中央档案馆

- 中央综治委

- 中国全国人大

- 中国全国政协

- 最高人民法院

- 全国最高检

- 解放日报网

- 中国外交部

- 中国国防部

- 中共青年团

- 国家发改委

- 中国教育部

- 中国科技部

- 中国工信部

- 中国国家民委

- 中国公安部

- 中国监察部

- 中国民政部

- 中国司法部

- 中国社保部

- 自然资源部

- 生态环境部

- 国家住建部

- 中国交通部

- 中国铁道部

- 中国水利部

- 农业农村部

- 中国商务部

- 文化和旅游部

- 卫生健康委

- 国家司法部

- 国务院新闻办

- 乡村振兴局

- 国务院国资委

- 国家防腐局

- 中国人民网

- 中国新华网

- 中国经济网

- 中国政府网

- 中国网网站

- 中国光明网

- 中国日报网

- 美国美联社

- 俄通社塔斯社

- 中国新闻网

- 中央联络部

- 旗 帜 网

- 中纪委监察部

- 京东商城网

评论网版权所有 ,未经书面授权禁止使用

Copyright © 2008-2011 by www.chinareview.com.cn all rights reserved.

浏览本网主页,建议将电脑显示屏的分辨率调为1024*768

京公网安备110108401150号 《中华人民共和国增值电信业务经营许可证》 编号:京ICP备17062725号-2

Copyright © 2008-2011 by www.chinareview.com.cn all rights reserved.

浏览本网主页,建议将电脑显示屏的分辨率调为1024*768

京公网安备110108401150号 《中华人民共和国增值电信业务经营许可证》 编号:京ICP备17062725号-2